Gemma 比 Mistral 强?Gemma 多平台使用指南

Gemma 比 Mistral 强?Gemma 多平台使用指南

2024年2月21日,来自 Google DeepMind 的 Gemma 团队宣布了一个突破性的进展——Gemma,这是基于 Gemini 技术研发的轻量级、前沿的开放模型。

DeepMind 提供了两种规模的 Gemma 模型——20亿参数和70亿参数。

70亿参数模型专为 GPU 和 TPU 的高效部署与开发而设计,而20亿参数模型则为 CPU 和移动设备应用提供了支持。

这两种模型均提供了预训练和细化调整(fine-tuned)的检查点,以便于研究者和开发者使用。

https://blog.google/technology/developers/gemma-open-models/

https://ai.google.dev/gemma

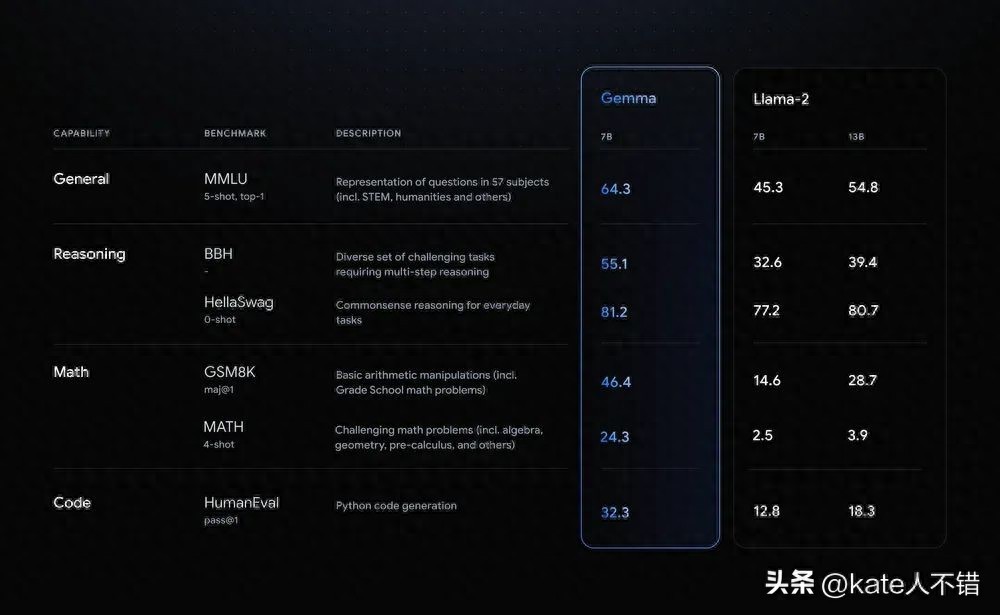

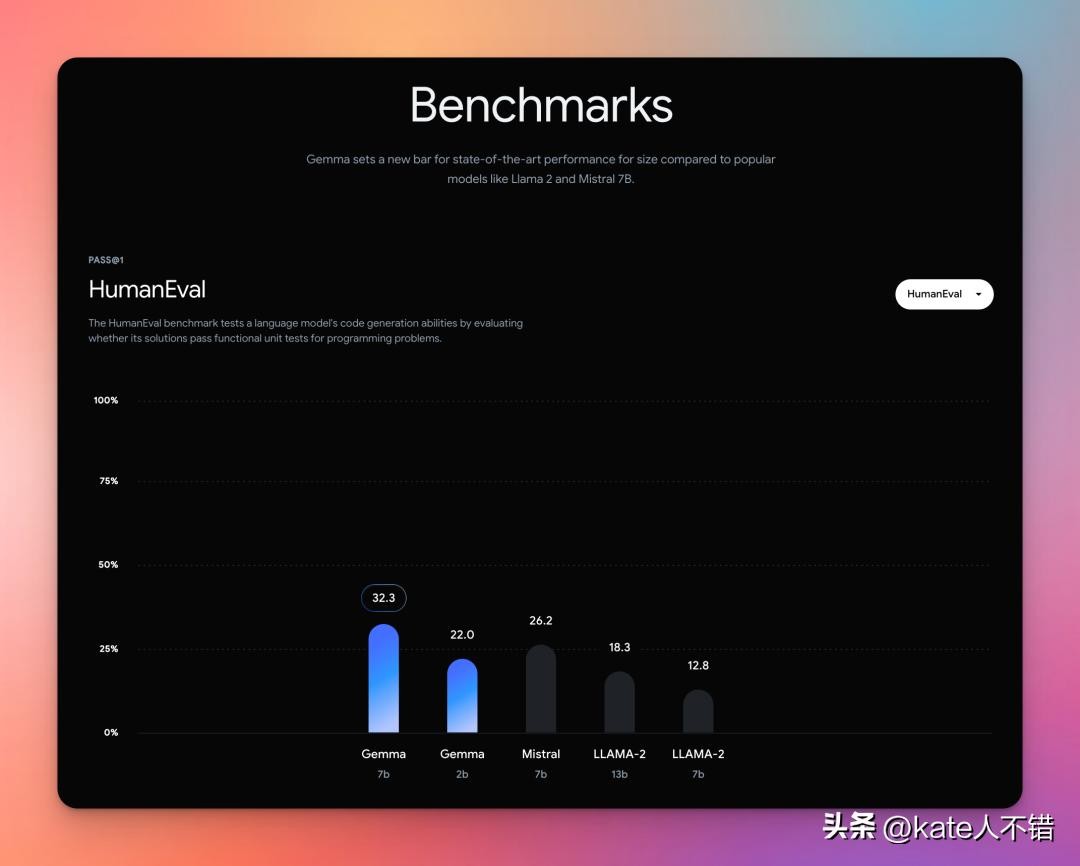

DeepMind 在博文和给出的动态图里展示的数据显示 Gemma 7B 性能出众;但一些博主不这么认为。

https://www.youtube.com/watch?v=1Mn0U6HGLeg

Gemma 使用指南:

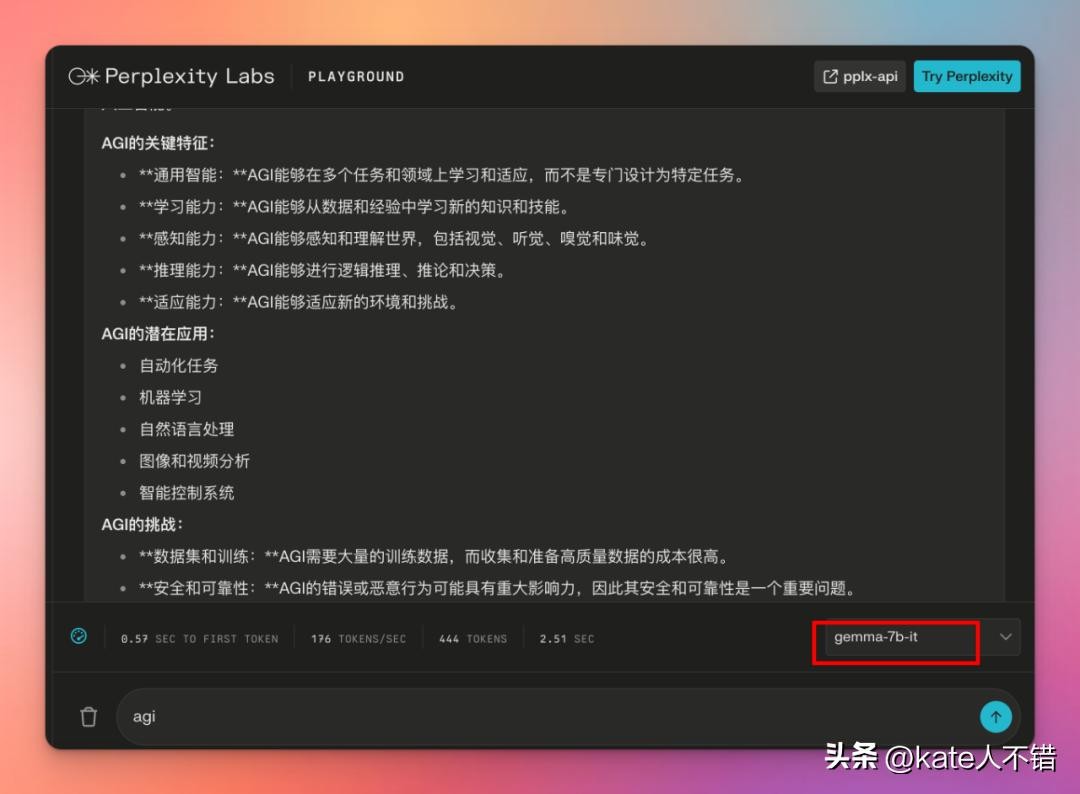

1. Perplexity

https://labs.perplexity.ai/

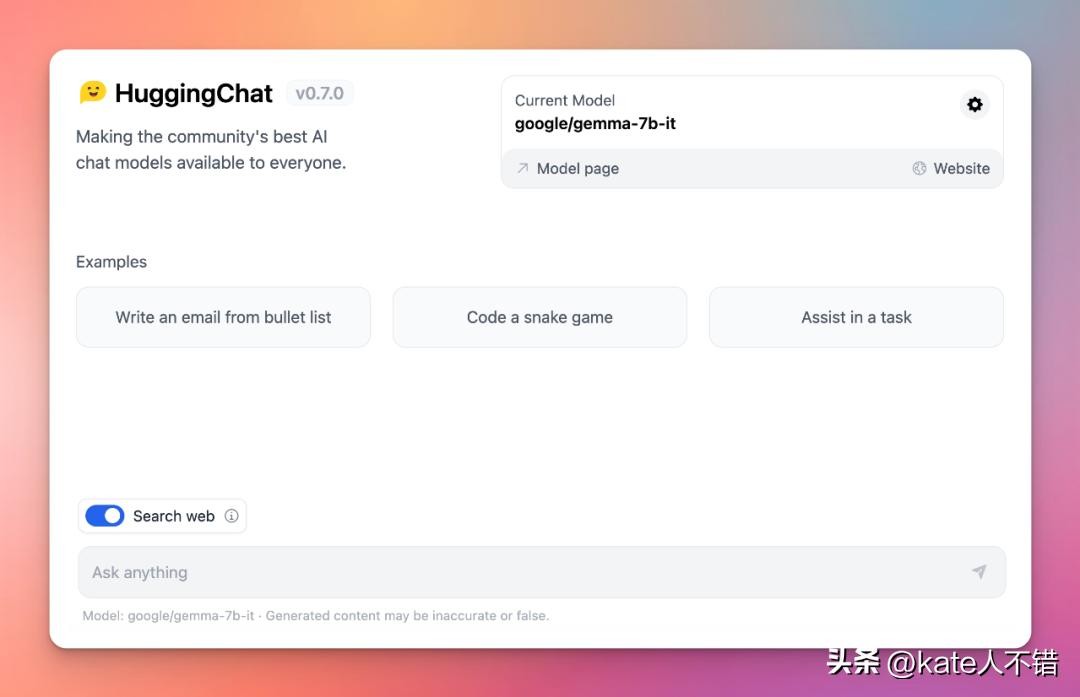

2. Hugging Face

https://huggingface.co/chat

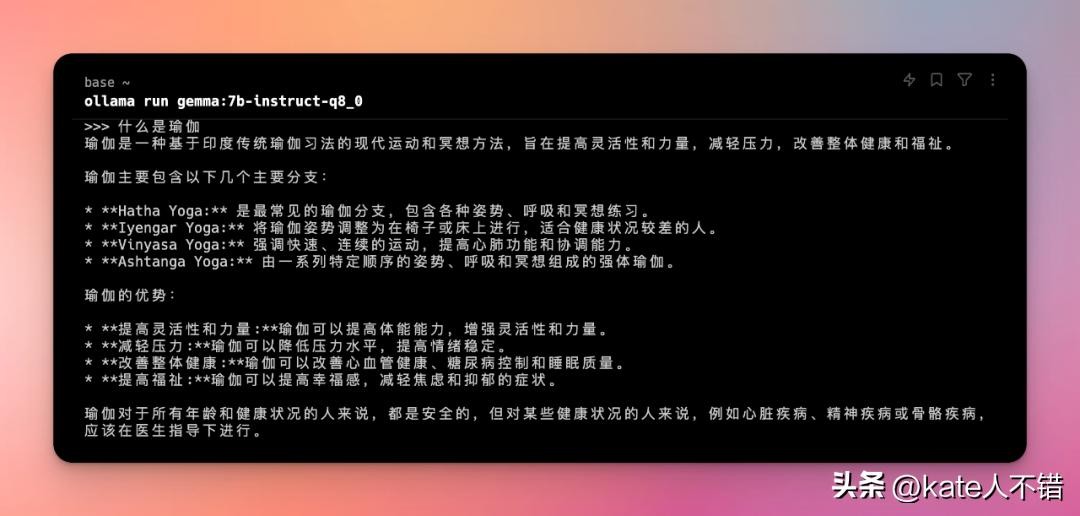

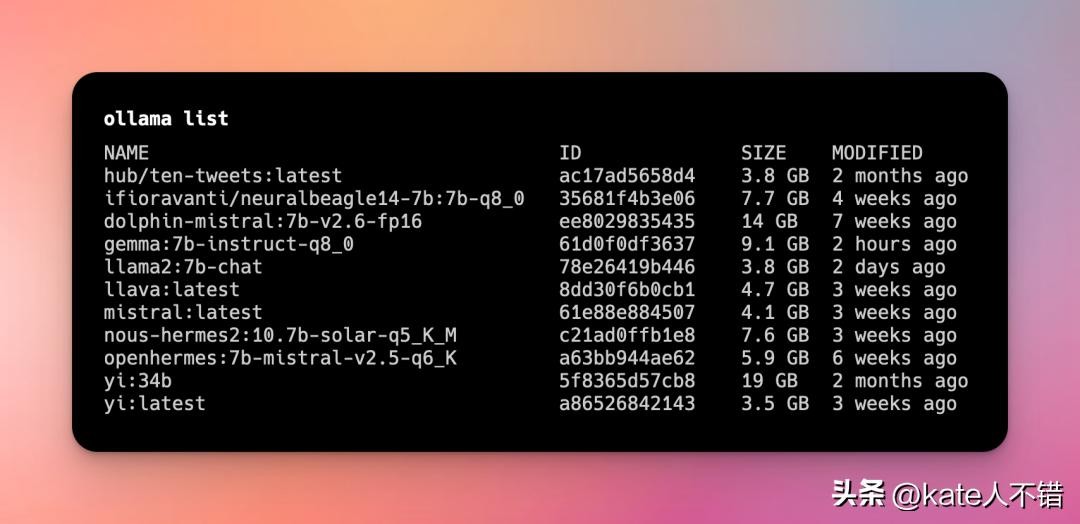

3. Ollama

https://ollama.com/library/gemma/tags

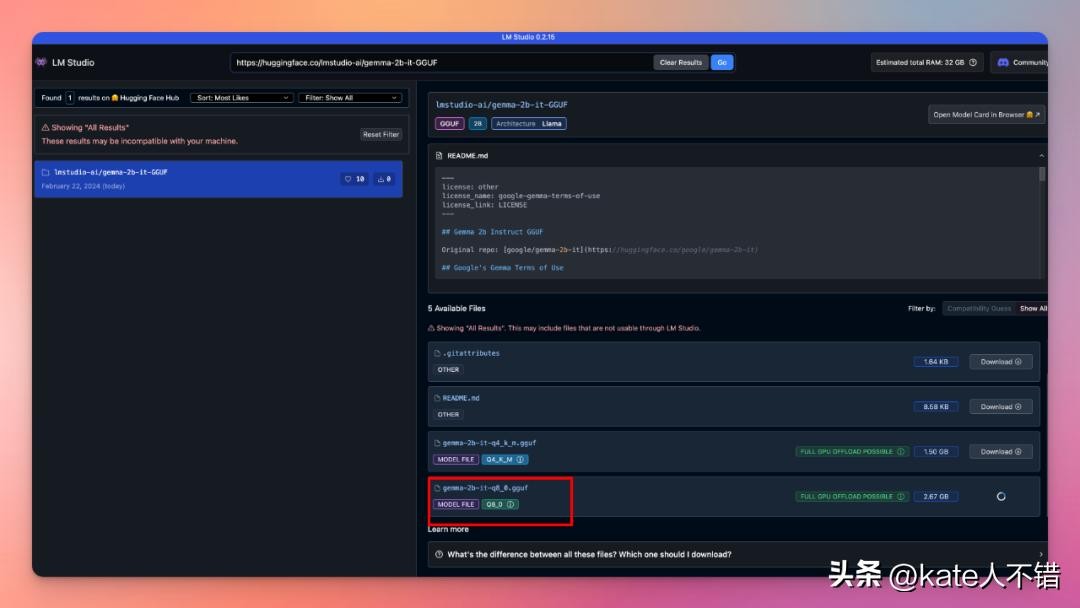

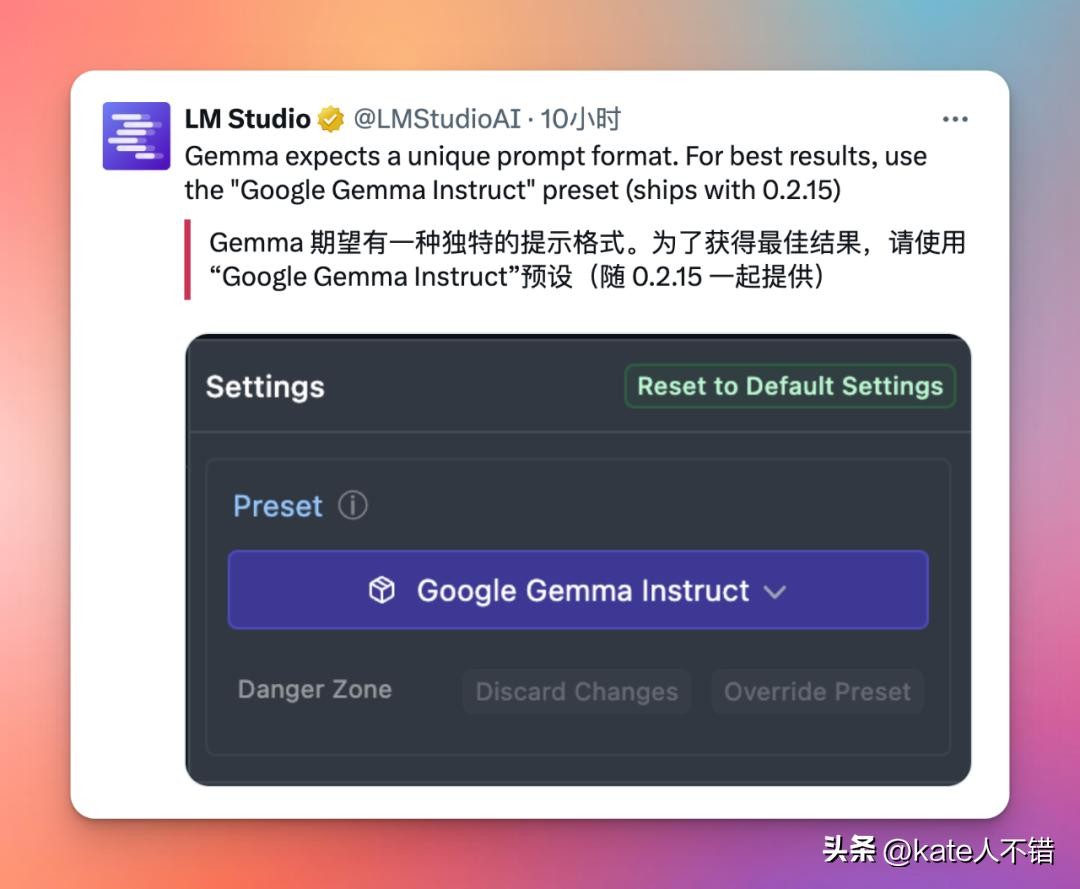

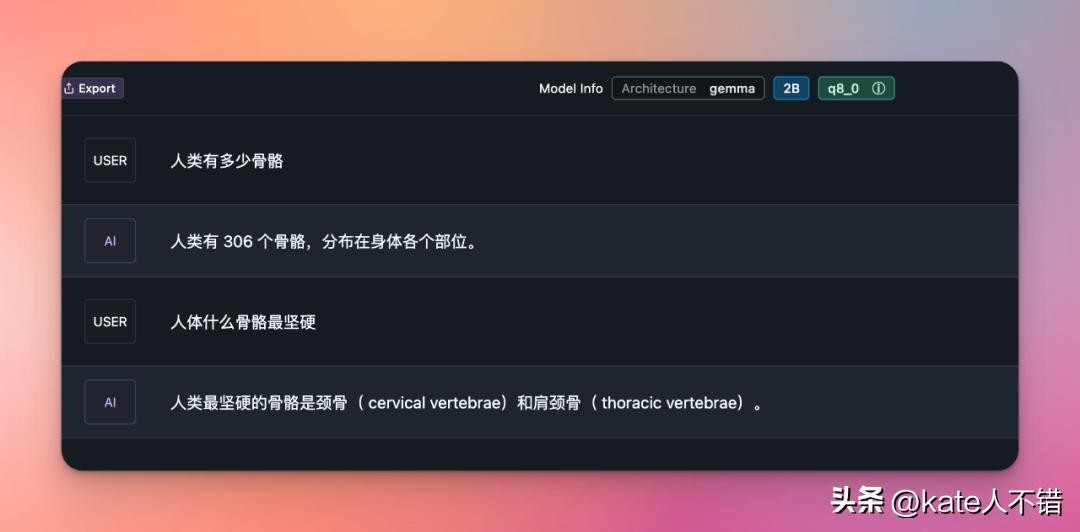

4. LM Studio

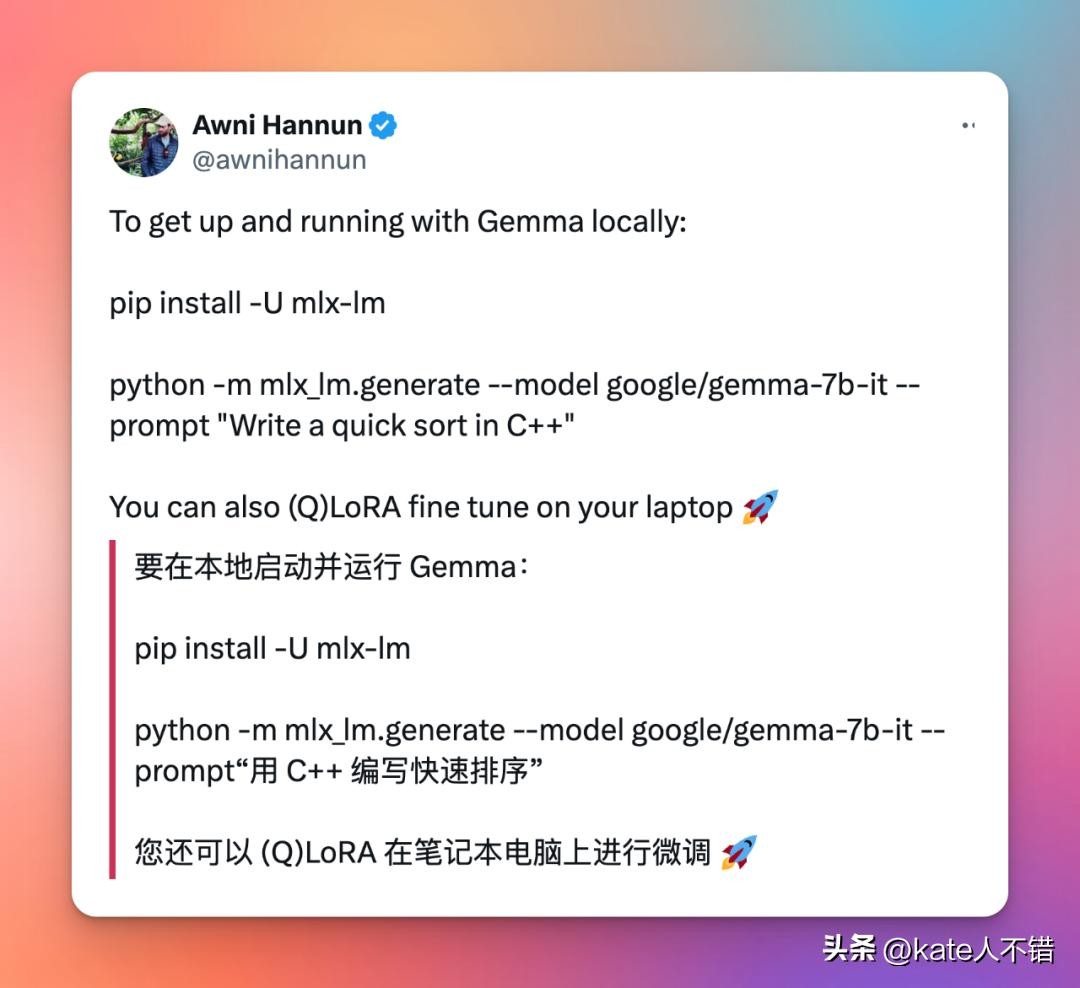

5. Apple MLX

https://huggingface.co/mlx-community

对在 Ollama 或 LM Studio里使用 Gemma 不满意的话,可以试下Apple MLX。

Gemma 模型可能一般,但是 Google 提供了一些详细的配套服务。

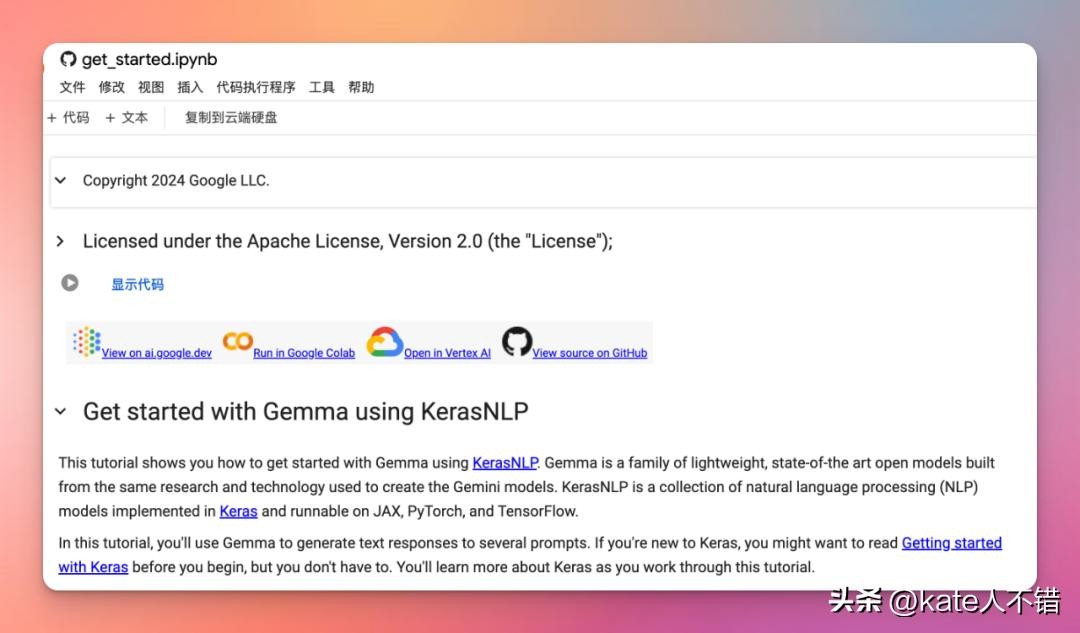

6. Colab- Gemma 模型入门

https://colab.research.google.com/github/google/generative-ai-docs/blob/main/site/en/gemma/docs/get_started.ipynb

免费用户就可以通过Colab 运行 Gemma。

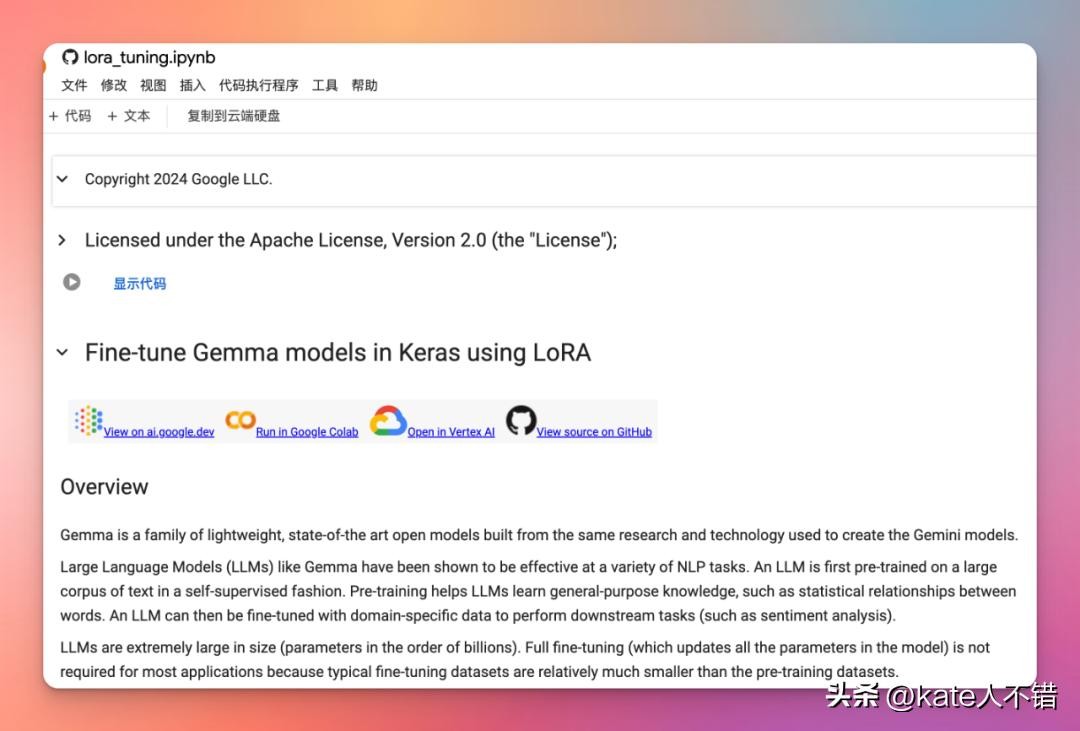

Colab-用 LORA 对 Gemma 模型进行微调

https://colab.research.google.com/github/google/generative-ai-docs/blob/main/site/en/gemma/docs/lora_tuning.ipynb

在多个GPUs/TPUs上微调 Gemma 模型

https://www.kaggle.com/code/nilaychauhan/keras-gemma-distributed-finetuning-and-inference

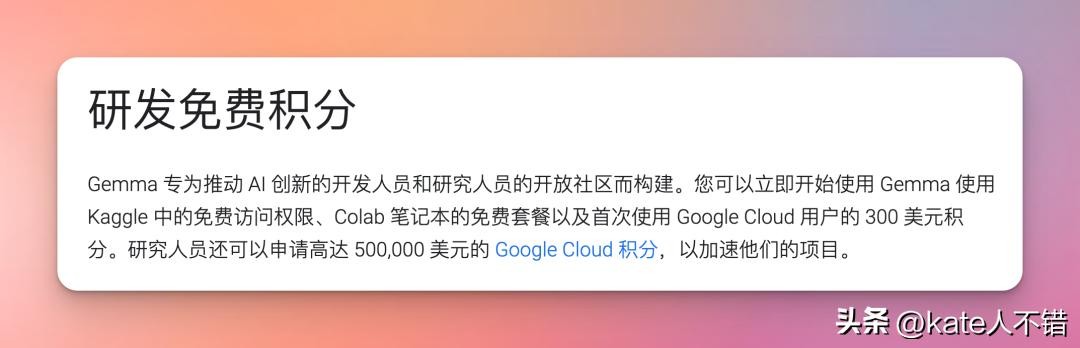

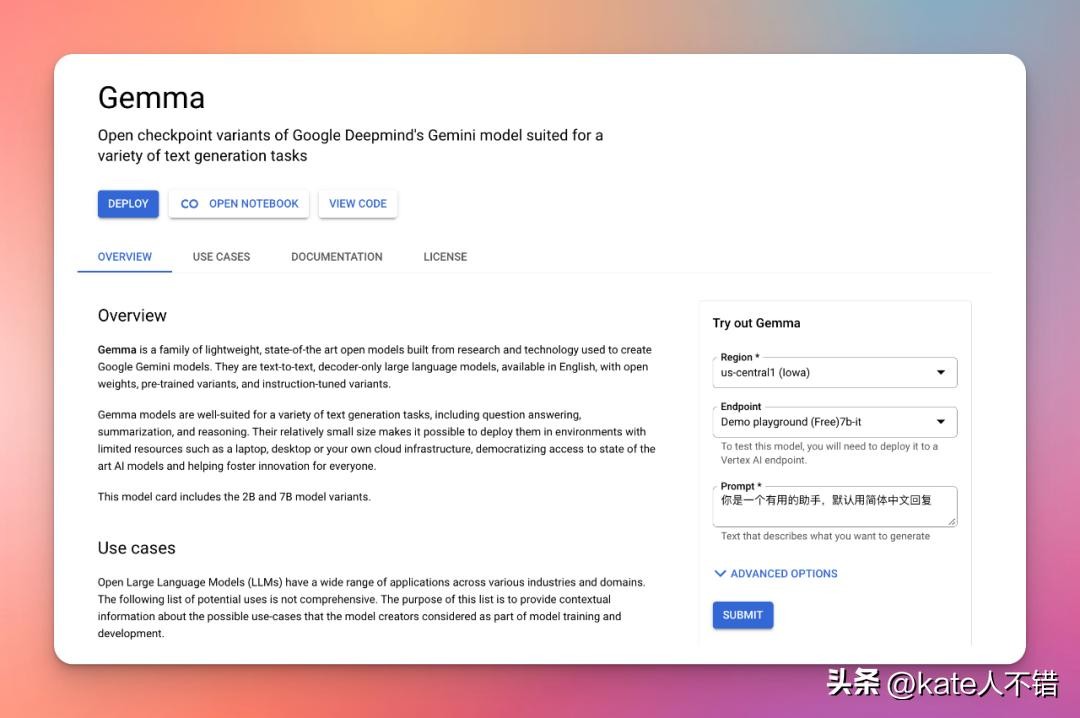

7. Google Vertex AI

首次使用 Google Cloud 用户还可以获得300美元积分,积分可用 Gemma 模型部署与训练。

https://console.cloud.google.com/vertex-ai/publishers/google/model-garden/335

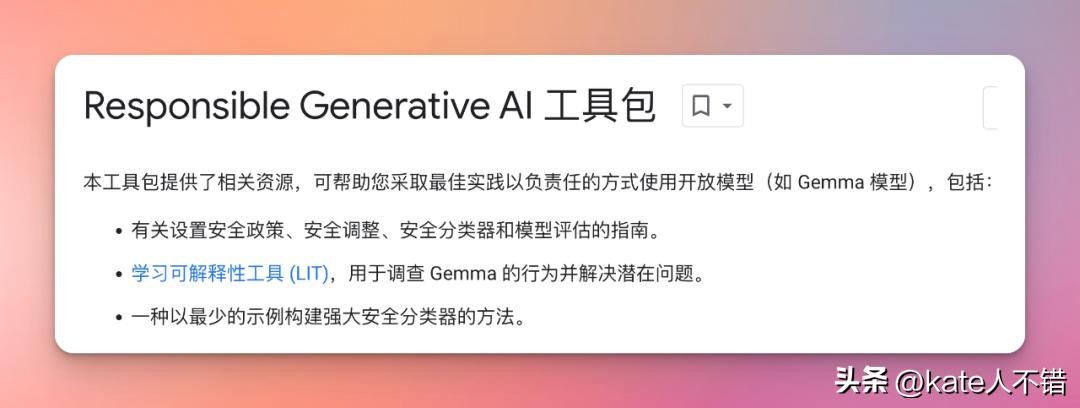

谷歌还提供了 Responsible Generative AI 工具包,为使用 Gemma 创建更安全的 AI 应用程序提供了指导和基本工具。

https://ai.google.dev/responsible?utm_source=agd&utm_medium=referral&utm_campaign=explore-responsible&utm_content&hl=zh-cn

就目前我电脑里 Ollama 现有的模型而言,我更喜欢 yi-6b、yi-34b、llava-7b、openhermes-7b-mistral-v2.5 模型。

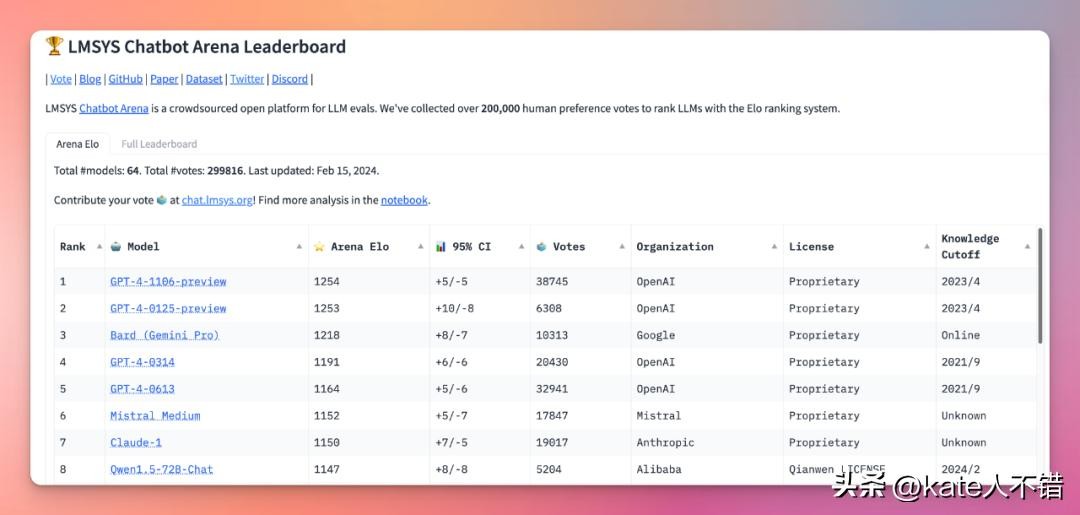

期待后续基于 Gemma 的模型在 lmsys 榜上有名。

https://huggingface.co/spaces/lmsys/chatbot-arena-leaderboard

-

- 贾跃亭又成老赖了!这次是欠款1.5亿,身在美国,但再次被限高!

-

2025-07-28 03:38:46

-

- 京西古刹—潭柘寺

-

2025-07-28 03:36:31

-

- 电梯“吃人”引民慌 市民乘坐需谨慎

-

2025-07-28 03:34:16

-

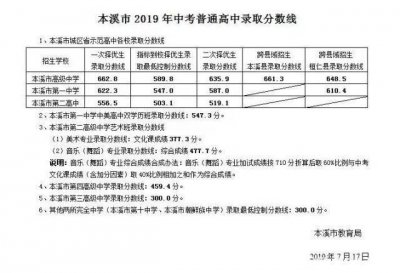

- 辽宁省本溪市有3大高中名校,其中有一所全国闻名

-

2025-07-28 03:32:01

-

- 十五本高分现言甜宠小说,深情不负丨治愈甜文丨互宠日常

-

2025-07-27 10:47:14

-

- 混合团体世界杯开拍 下午5点国乒首战对瑞典

-

2025-07-27 10:44:59

-

- 港产王妃文雅丽

-

2025-07-27 10:42:44

-

- 防火防盗防室友?女生偷拍室友发裸照到网上,恶行曝光

-

2025-07-27 10:40:29

-

- 体育生能考什么大学?我为什么推荐这3类大学?

-

2025-07-27 10:38:14

-

- 神童张炘炀现状:博士读了八年需要父母接济,真天才还是伤仲永?

-

2025-07-27 10:35:59

-

- 情感与挑战交织——《白百合》:日本限制级电影的背后

-

2025-07-27 10:33:44

-

- 每日一草:播娘蒿

-

2025-07-27 10:31:29

-

- 杭州老板娘穿着清凉被举报哭诉自己被骚扰和欺负

-

2025-07-27 10:29:14

-

- 被儿子带入影视圈,因拍《战狼》一战成名,将成百亿票房女演员

-

2025-07-27 10:26:59

-

- Whatfeel:999元的电动独轮车时代真的来了

-

2025-07-27 10:24:44

-

- 【注意】微信,如何开启收款到账语音提醒!

-

2025-07-27 10:22:29

-

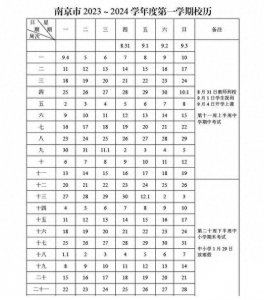

- 注意了!今年开学时间有调整

-

2025-07-27 10:20:14

-

- 上联是:一人从众,众里寻她千百度。下联请今日头条的联友赐教?

-

2025-07-27 10:17:59

-

- 全国一等奖!安宁这支小学生合唱团唱响“安宁小调”

-

2025-07-27 10:15:43

-

- 《山海经》中的九天玄女,本以为是传说,然而确有其人,还很美丽

-

2025-07-27 10:13:28

翁帆的第一任丈夫照片和资料介绍,翁帆看不上普通的小职员

翁帆的第一任丈夫照片和资料介绍,翁帆看不上普通的小职员 和谐玉溪多少钱一包?硬和谐40元一包(烟味绵长)

和谐玉溪多少钱一包?硬和谐40元一包(烟味绵长)